年来,文本到图像(T2I)模型的快速发展为人工内容生成带来了革命性的变化,这些模型在不到两年的时间内就能够生成高质量、多样性和创造性的图像。然而,大多数现有的T2I模型存在一个问题,它们难以有效地与自然语言进行交流,通常需要复杂的提示调整和特定的词语组合。

https://minidalle3.github.io/

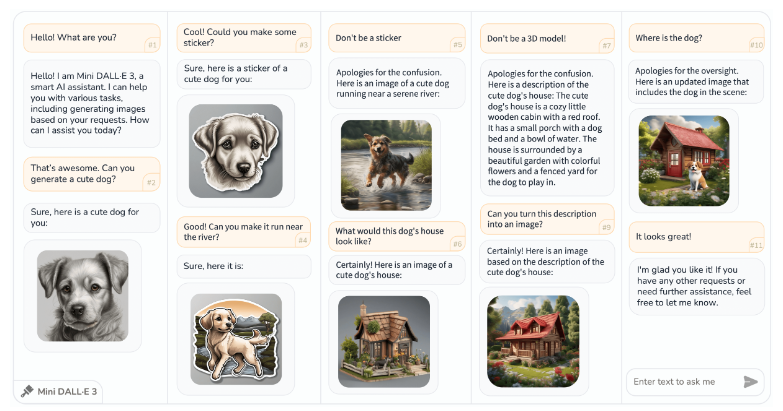

受到DALLE3的启发,研究人员提出了一种新的任务,即交互式文本到图像(iT2I),使人们能够与大型语言模型(LLM)进行自然语言交互,实现高质量图像生成和问题回答。他们还提出了一种简单的方法,通过提示技巧和现成的T2I模型,来扩展LLM以实现iT2I,而不需要额外的训练。

研究人员在不同的LLM下,如ChatGPT、LLAMA、Baichuan等,对他们的方法进行了评估,展示了这种方法可以方便且低成本地为任何现有的LLM和文本到图像模型引入iT2I功能,同时对LLM的固有功能,如问题回答和代码生成,影响较小。

这项工作有望引起广泛关注,为提高人机交互体验以及下一代T2I模型的图像质量提供启发。文章的研究对于促进人机交互和改进图像生成质量具有潜在的重要意义。

[免责声明]如需转载请注明原创来源;本站部分文章和图片来源网络编辑,如存在版权问题请发送邮件至398879136@qq.com,我们会在3个工作日内处理。非原创标注的文章,观点仅代表作者本人,不代表炎黄立场。